Un equipo de investigadores liderado por la Universitat de València, en colaboración con la University of Oxford (UK) y el Max Planck Institute of Biogeochemistry (Alemania) han proporcionado una revisión de algoritmos de machine learning capaces de mejorar las estimaciones de variables críticas para la monitorización de la Tierra. El trabajo, que contribuye a mejorar la predicción climática y su compresión, aparece publicado en la revista National Science Review.

La Tierra es un sistema complejo y dinámico, donde muchos procesos se relacionan entre sí. Es un sistema difícil de monitorizar y predecir. Para ello, físicos, matemáticos e ingenieros desarrollan modelos capaces de explicar las observaciones y medidas obtenidas por sensores a bordo de satélite o estaciones de medida repartidas por todo el planeta. Los modelos clásicos se han basado en codificar e implementar en forma de ecuaciones nuestro conocimiento físico. Con esos modelos se puede estimar la temperatura superficial de la tierra, la concentración de ozono atmosférico o la salinidad de los océanos. Estos modelos son, sin embargo, muy costosos computacionalmente y requieren asunciones sobre los procesos involucrados y sus relaciones, que a menudo son muy simplistas o incluso arbitrarias. En la actualidad, la alternativa viene desde el aprendizaje estadístico (machine learning) que plantea modelos muy flexibles y eficaces para la estimación de variables de interés a partir de datos y observaciones.

Tras publicar recientemente en Nature diferentes algoritmos capaces de aprender las relaciones causales entre variables a partir de datos, ahora el investigador de la Universitat de València Gustau Camps-Valls, junto con científicos de la Oxford University y el Max Planck Institute of Biogeochemistry (Alemania), argumenta en un nuevo trabajo que los algoritmos actuales están limitados en distintos sentidos. El artículo, que aparece en la revista National Science Review, presenta una visión crítica al respecto y aporta posibles soluciones a este problema en el futuro. “Los algoritmos actuales, por ejemplo, se emplean en sus formas más básicas, y a menudo no son consistentes respecto a las más elementales leyes de la física; simplemente interpolan a partir de datos pero no han aprendido nada especial”, comenta Gustau Camps-Valls, profesor del Departament d’Enginyeria Electrònica y responsable del grupo de Procesado de Imágenes y Señales (ISP) del IPL (Image Processing Laboratory), en el Parc Científic de la Universitat de València. “Proponemos nuevos algoritmos que puedan incluir restricciones en forma de leyes fundamentales, y nuevos modelos de caja negra más comprensibles que nos ayuden a aprender de todo aquello que aportan los datos”, concluye.

Los algoritmos que se proponen no solo pretenden ser más precisos y consistentes, sino más sencillos e interpretables. “La interpretabilidad es tal vez el tema crítico cuando estamos hablando de modelos de machine learning”, señala el Dino Sejdinovic, profesor del Departamento de Estadística de la Oxford University. “Se trata de una característica que se ha sacrificado durante demasiado tiempo en aras de la precisión, y esto no puede continuar así cuando hablamos de modelos cuyos resultados y predicciones tienen implicaciones en medio ambiente y economía”.

Referencia

“A Perspective on Gaussian Processes for Earth Observation”.

Gustau Camps-Valls, Dino Sejdinovic, Jakob Runge, Markus Reichstein

National Science Review, 2019.

Oxford Academic Press, Chinese Academy of Science.

https://academic.oup.com/nsr/advance-article/doi/10.1093/nsr/nwz028/5369430

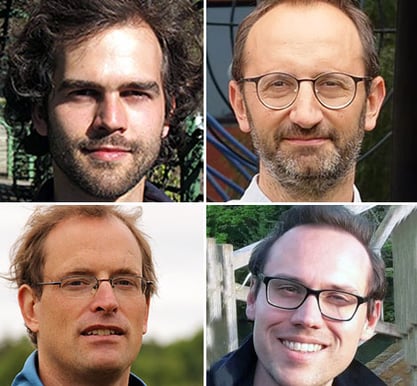

De izquierda a derecha y de arriba abajo, Jacob Runge, Gustau Camps-Valls, Marcus Reichstein y Dino Sejdinovic